상호참조해결 레이블을 얻는 것은 굉장히 어려운 일이다. 특히 한국어는 더 그렇다.

따라서 레이블이 없는 데이터를 최대한 활용해 coreference resolution model의 성능을 올릴 수 있다면 좋을 것이다.

이 논문에서는 그 방법에 대해 설명한다.

1. Introduction

최신 Coreference Resolution 모델들 중 대부분은 mention의 vector representation을 이용해 clustering을 진행한다. 따라서 이 mention representation은 굉장히 중요하다. SpanBERT를 이용해 embedding을 한 모델이 BERT로 embedding을 한 모델보다 성능이 우수하다는 점에서도 이를 알 수 있다.

하지만 BERT든 SpanBERT든 self-supervised learning 결과로 나타난 representation은 coreference resolution 태스크에서 필요로하는 mention representation과는 거리가 멀다. 그렇다면 어떤 self-supervised task를 이용해야 coreference resolution을 위한, 더 나은 mention representation을 생성할 수 있을까?

이 논문에서는 corefence model에 바로 적용하는 self-supervision tasks를 제시한다. 이를 통해 mention representation과 Coreference Resolution의 정확도가 향상된다고 한다.

이 논문에서 제시하는 self-supervision 방법에는 두 가지가 있다.

1. 동일한 이름이 하나의 다큐먼트에 여러 번 나오는 경우가 있다. 이 때, 이 name mention들은 상호참조하는 경우가 대다수이다. 따라서 이들의 mention representation의 similarity를 높이며 학습시킬 수 있다.

2. 대명사는 특정 mention과 연결되기 마련인데, 이 대명사를 제대로 예측(정확도를 최대화)할 수 있도록 mention representation을 optimize한다.

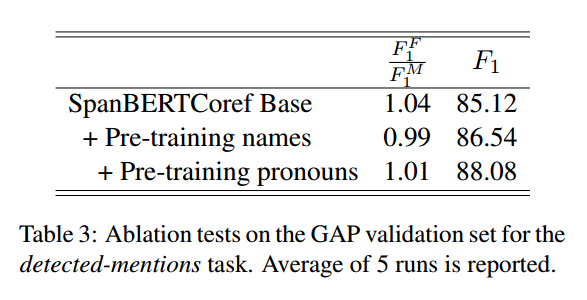

이러한 방식을 통해 GAP dataset에 대해 SOTA를 찍었다.

2. Baseline Model

Baseline Model로는 SpanBERT에 Lee et al(2018)의 모델을 올린 end-to-end모델을 이용한다.

3. Pre-training Process

목표는 정답셋이 없는 unlabelled data를 이용해 mention representation을 pre-training하여 이후 상호참조해결 시 정확한 군집화가 가능하도록 하는 것이다.

3-1. Pre-training via Name Masking

아래의 예시와 같이 이름이 동일한 형태로 나타난다면 이 이름들은 동일한 의미를 지닐 확률이 높다.

이를 이용한다면 mention representation이 더 잘 될 것이다.

순서

1. 이름이 반복적으로 여러 개 있는 문장들을 가져온다.

2. 이름들 중 일부를 마스킹하거나 랜덤 토큰으로 변경한다.

3. 마스킹된 이름을 올바르게 클러스터링 시킬 수 있도록 coreference 모델을 학습시킨다.

3-2. Pre-training via Pronoun Masking

“Bob knew Alice and thought very highly of [MASK]”이라는 문장이 있다고 생각해보자.

저 [MASK]가 대명사일 때, 우리는 이 마스크에 Alice를 의미하는 her이 들어갈 것이라고 예측가능하다.

이 [MASK]의 vector representation이 맥락을 이용하여 대명사를 예측하도록 충분하도록 학습시킬 수 있다는 것이다.

순서

S 는 personal pronouns의 집합이라고 하자.

1. i 번째 mention인 대명사 w ∈ S 가 있는 문장이 주어졌을 때, 대명사를 [MASK]로 변경하고 mention representation ri 를 구한다.

2. 하나의 히든 레이어를 가지는 feedforward neural network를 이용해서 ri에서 부터 대명사를 예측한다.

3. ground-truth 대명사인 w에 대한 cross-entropy loss를 구하고 학습한다.

CrossEntropy(softmax(FFNN(ri)), w)

4. Fine-tuning

GAP Dataset에 대한 fine tuning 진행

GAP 데이터셋은 일부만 레이블링이 된 데이터이다.

데이터 셋의 특성을 고려해서 이 논문에서는 gold mention으로 필터링된 올바른 선행사의 log-likelihood만을 최적화한다. 이를 L1(D)로 표현할 수 있으며 여기서 D는 다큐먼트를 의미한다.

추가로 correct mention detection 학습을 위해, mention auxiliary loss인 L2(D)를 crossentropy 형식으로 추가하여 mention score sm을 학습하도록 한다.

결과적으로 L1(D) + λ · L2(D)를 최적화 하는 것이다.

5. 결과