Key(GOLD) entity의 집합을 K라고 하고, Response(PREDICTED) entity의 집합을 R이라고 하자.

각 개체(Entity)는 한 개 이상의 언급(Mention)을 가진다.

각 메트릭들은 서로 다른 방식으로 Precision과 Recall을 측정한다.

1. MUC

- 링크 기반 측정 방법으로 key와 response 각각에 대한 recall과 precision을 측정한다.

- Recall : (The number of common links between entities in K and R) / (The number of links in K)

- Precision : (The number of common links between entities in K and R) / (The number of links in R)

- 한계 :

1) 이 메트릭은 하나의 개체(Entity)에 개체와 관련 없는 것을 포함한 여러 개의 언급(Mention)이 때려 박혀 있을 때 성능이 지나치게 잘나온다. 만약 하나의 개체 집합에 모든 언급들이 포함되어 있으면 Precision을 크게 낮추지 않으면서도 Recall이 100%가 나온다.

2) 언급이 1개인 개체는 무시한다.

2. B3

B3는 이러한 MUC의 한계를 지적하며 나온 메트릭이다.

MUC와 달리 B3는 언급(Mention)을 기반으로 하여 성능을 측정하는 방법이다.

각 언급에 대한 Recall과 Precision을 구하고 이들을 평균을 내어 측정한다.

이 방법은 주어진 언급을 포함하는 개체의 전체 predicted와 gold mention cluster의 비율을 측정한다.

3. CEAFe

개체(entity) 기반의 매트릭으로, key의 엔티티와 response의 엔티티들 간에 일-대-일 맵핑으로 Similarity Score를 확인한다. 그리고 그 값 중 가장 높은 값을 선별한다. 즉, 각 response의 엔티티는 key의 엔티티들 중 최적의 엔티티로 맵핑 된다.

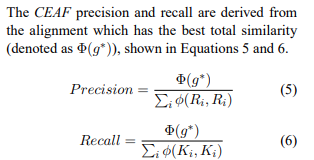

CEAF에서 response와 key의 유사성을 판별하는 함수(Φ4(𝑔))와 Recall, Precision을 구하는 방법은 다음과 같다.

4. CoNLL F1

위의 세 메트릭들의 f1 score를 평균낸 값

Reference:

규칙과 기계학습을 이용한 한국어 상호참조해결(박천음, 2016)

evaluation metrics for end-to-end coreference resolution systems(Jie Cai et al., 2010)

A model-Theoretic Coreference Scoring Scheme(Marc Vilain et al., 1995)